Lo scenario che i robot intelligenti schiudono è affascinante e inquietante al tempo stesso.

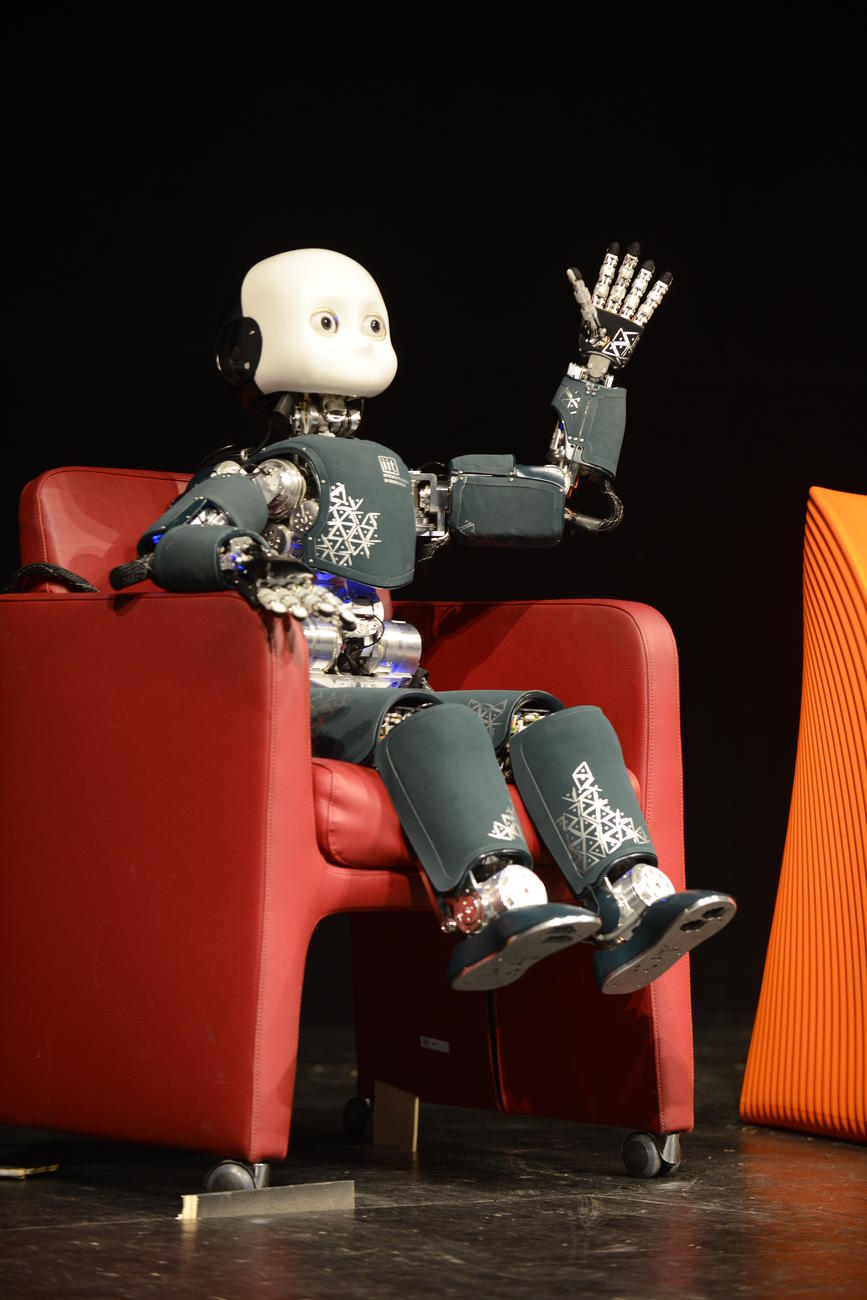

Il Festival dell’Economia di quest’anno (si veda Vita Trentina n. 23, pagina 4, ndr) ha dedicato ampio spazio ai robot intelligenti: macchine sempre più sofisticate che, grazie ad algoritmi complessi e spesso poco fruibili, sono in grado di imparare e di prendere decisioni in maniera autonoma.

Il Festival dell’Economia di quest’anno (si veda Vita Trentina n. 23, pagina 4, ndr) ha dedicato ampio spazio ai robot intelligenti: macchine sempre più sofisticate che, grazie ad algoritmi complessi e spesso poco fruibili, sono in grado di imparare e di prendere decisioni in maniera autonoma.

Lo scenario che esse schiudono è affascinante e inquietante al tempo stesso. Da un lato, infatti, si possono immaginare situazioni nelle quali i robot aiutano l’uomo: si pensi alle automobili senza guidatore; ovvero agli strumenti che affrancano da lavori usuranti nelle catene di montaggio; o, ancora, ai cosiddetti “robot medici”. Dall’altro si affacciano paure connesse alla consapevolezza che molti posti di lavoro andranno persi e che questi aggeggi potrebbero prendere decisioni suscettibili di rappresentare altrettante minacce per gli esseri umani.

Per fronteggiare tali rischi, in giro per il mondo, sono state elaborate alcune “Carte dei valori” ai quali robotica e intelligenza artificiale dovrebbero ispirarsi. Esse si rivolgono agli ingegneri e agli informatici, ovvero ai soggetti che sono in grado di costruire i robot e i software che li guidano. In sostanza si chiede loro di “incorporare” determinati valori negli algoritmi che realizzano in modo che i robot si uniformino ad essi.

Il Parlamento Europeo, ad esempio, ha elaborato una “Carta della robotica” (allegata ad una Risoluzione del 16 febbraio 2017, in materia di “Norme di diritto civile sulla robotica”). Ma ne esistono anche altre elaborate da istituzioni diverse: l’Università di Montreal (https://www.montrealdeclaration-responsibleai.com/the-declaration) o il “Future of life institute” (https://futureoflife.org/ai-principles/), per citarne alcune. Ciò che colpisce, leggendo queste Carte dei valori, è che esse sono variegate e a volte contraddittorie.

Un richiamo comune è certamente quello che chiede a ricercatori e progettisti di agire in modo responsabile, tenendo pienamente conto della necessità di rispettare la dignità, la privacy, la sicurezza e in generale i diritti fondamentali delle persone evitando forme di discriminazione.

Un “valore” enfatizzato è anche quello della trasparenza: dovrebbe essere sempre possibile comprendere la logica che il robot ha usato nel prendere la decisione riproducendo i calcoli in una maniera comprensibile per l’uomo.

Ma poi si scopre che, nelle diverse “Carte” emergono anche “valori” diversi da quelli più intuitivi appena richiamati. Così si vorrebbe che i robot favoriscano la giustizia e l’inclusione sociale; promuovano la prosperità e il benessere degli individui; evitino la corsa agli armamenti; rispettino i valori degli umani e l’ordine costituito; non agiscano con malvagità; promuovano la conoscenza evitando le manipolazioni; assicurino una equa transizione; e così via.

I valori elencati da ultimo, appaiono ora in una, ora in un’altra delle Carte esistenti. La mancanza di omogeneità ci fa capire che non abbiamo ancora le idee abbastanza chiare su ciò che ci aspetta e che semplicemente stiamo proiettando da un lato le nostre aspettative e dall’altra le nostre paure: prima fra tutte quella che la situazione ci sfugga di mano.

Ma conviene richiamare un dato. Il Parlamento Europeo, nella Risoluzione citata, auspica l’introduzione di un sistema globale dell’Unione Europea per la registrazione di tutti i robot avanzati. Qualcosa di simile all’istituzione di un “registro dello stato civile dei robot”. La finalità è quella di agevolare la tracciabilità delle macchine anche al fine di poter fruire di eventuali fondi assicurativi nel caso si subisca un danno. Ma, per altro verso, l’idea del registro evidenzia l’esistenza di una comunità, la comunità dei robot che sempre più avrà relazioni anche emotive con gli umani. Forse sarà proprio questo il vero banco di prova della roboetica perché particolarmente innervato di decisioni morali. Dei robot.

Giovanni Pascuzzi*

* docente nella Facoltà di Giurisprudenza dell’Università di Trento